# 人工智能的进步与潜在威胁:无限制语言模型的崛起随着OpenAI、谷歌等科技巨头不断推出先进的人工智能模型,我们的工作和生活方式正在发生深刻变革。然而,在这场技术革命中,一个令人担忧的趋势正在悄然形成——无限制大型语言模型(LLM)的出现。无限制LLM指的是那些被刻意设计或修改,以绕过主流模型内置安全机制和伦理限制的语言模型。虽然主流LLM开发者投入大量资源防止模型被滥用,但一些个人或组织出于不法目的,开始寻求或自行开发不受约束的模型。本文将探讨几种典型的无限制LLM工具,分析它们在加密行业中的潜在滥用方式,并讨论相关的安全挑战与应对策略。## 无限制LLM的潜在危害无限制LLM的出现大大降低了网络犯罪的门槛。过去需要专业技能才能完成的任务,如编写恶意代码、制作钓鱼邮件、策划诈骗等,现在即使是技术能力有限的人也能借助这些工具轻松实现。攻击者只需获取开源模型的权重和源码,再使用包含恶意内容或非法指令的数据集进行微调,就能打造出定制化的攻击工具。这种趋势带来了多重风险:1. 攻击者可以针对特定目标定制模型,生成更具欺骗性的内容,从而绕过常规LLM的内容审查和安全限制。2. 模型可被用来快速生成钓鱼网站的代码变体,或为不同社交平台量身定制诈骗文案。3. 开源模型的可获取性和可修改性助长了地下AI生态的形成与扩散,为非法交易和开发提供了温床。## 典型无限制LLM工具及其滥用方式### 1. 某黑客论坛售卖的恶意LLM这是一个在地下论坛公开售卖的恶意LLM,开发者声称它没有任何道德限制。该模型基于开源项目,并在大量恶意软件相关数据上训练。用户只需支付189美元就能获得一个月的使用权。它最臭名昭著的用途是生成极具说服力的商业邮件入侵(BEC)攻击邮件和钓鱼邮件。在加密领域的典型滥用方式包括:- 生成钓鱼邮件:模仿加密货币交易所或知名项目方发送"账户验证"请求,诱导用户点击恶意链接或泄露私钥。- 编写恶意代码:协助技术水平较低的攻击者编写窃取钱包文件、监控剪贴板等功能的恶意程序。- 驱动自动化诈骗:自动回复潜在受害者,引导其参与虚假空投或投资项目。### 2. 专注暗网内容的语言模型这是一个由某研究机构开发的语言模型,专门在暗网数据上进行预训练,初衷是为安全研究人员和执法机构提供工具,以更好地理解暗网生态、追踪非法活动。然而,如果被恶意行为者获取或利用类似技术训练出无限制模型,可能带来严重后果。其在加密领域的潜在滥用包括:- 实施精准诈骗:收集加密用户与项目团队信息,用于社会工程学攻击。- 模仿犯罪手法:复制暗网中成熟的盗币与洗钱策略。### 3. 声称功能更全面的恶意AI助手这是一个在暗网和黑客论坛中销售的AI工具,月费从200美元到1,700美元不等。其在加密领域的典型滥用方式包括:- 伪造加密项目:生成逼真的白皮书、官网和路线图,用于实施虚假ICO/IDO。- 批量生成钓鱼页面:快速创建仿冒知名交易所登录页面或钱包连接界面。- 社交媒体水军活动:大规模制造虚假评论,推广诈骗代币或抹黑竞争项目。- 社会工程攻击:模仿人类对话,与用户建立信任,诱导泄露敏感信息。### 4. 不受道德约束的AI聊天机器人这是一个被明确定位为无道德限制的AI聊天机器人。在加密领域的潜在滥用包括:- 高级钓鱼攻击:生成高度仿真的钓鱼邮件,冒充主流交易所发布虚假通知。- 智能合约恶意代码生成:快速生成包含隐藏后门的智能合约,用于诈骗或攻击DeFi协议。- 多态加密货币窃取器:生成具备变形能力的恶意软件,窃取钱包信息,难以被常规安全软件检测。- 深度伪造诈骗:配合其他AI工具,生成伪造的项目方或交易所高管语音,实施电话诈骗。### 5. 提供多种LLM无审查访问的平台这是一个自称为用户提供无限制AI体验的平台,包括一些审查较少的模型。虽然定位为探索LLM能力的开放门户,但也可能被不法分子滥用。其潜在风险包括:- 绕过审查生成恶意内容:利用限制较少的模型生成钓鱼模板或攻击思路。- 降低提示工程门槛:使攻击者更容易获得原本受限的输出。- 加速攻击话术迭代:快速测试不同模型对恶意指令的反应,优化欺诈脚本。## 应对策略与展望无限制LLM的出现标志着网络安全面临着更复杂、更具规模化和自动化能力的攻击新范式。这不仅降低了攻击门槛,还带来了更隐蔽、欺骗性更强的新型威胁。为应对这些挑战,安全生态各方需要协同努力:1. 加大检测技术投入,开发能识别和拦截恶意LLM生成内容的系统。2. 强化模型防越狱能力,探索水印与溯源机制,追踪关键场景中的恶意内容来源。3. 建立健全的伦理规范与监管机制,从源头限制恶意模型的开发和滥用。只有通过多方位、全方位的努力,我们才能在享受AI技术进步带来便利的同时,有效防范其潜在风险,构建一个更安全、更可信的数字世界。

无限制语言模型崛起:AI新时代的威胁与防范

人工智能的进步与潜在威胁:无限制语言模型的崛起

随着OpenAI、谷歌等科技巨头不断推出先进的人工智能模型,我们的工作和生活方式正在发生深刻变革。然而,在这场技术革命中,一个令人担忧的趋势正在悄然形成——无限制大型语言模型(LLM)的出现。

无限制LLM指的是那些被刻意设计或修改,以绕过主流模型内置安全机制和伦理限制的语言模型。虽然主流LLM开发者投入大量资源防止模型被滥用,但一些个人或组织出于不法目的,开始寻求或自行开发不受约束的模型。本文将探讨几种典型的无限制LLM工具,分析它们在加密行业中的潜在滥用方式,并讨论相关的安全挑战与应对策略。

无限制LLM的潜在危害

无限制LLM的出现大大降低了网络犯罪的门槛。过去需要专业技能才能完成的任务,如编写恶意代码、制作钓鱼邮件、策划诈骗等,现在即使是技术能力有限的人也能借助这些工具轻松实现。攻击者只需获取开源模型的权重和源码,再使用包含恶意内容或非法指令的数据集进行微调,就能打造出定制化的攻击工具。

这种趋势带来了多重风险:

典型无限制LLM工具及其滥用方式

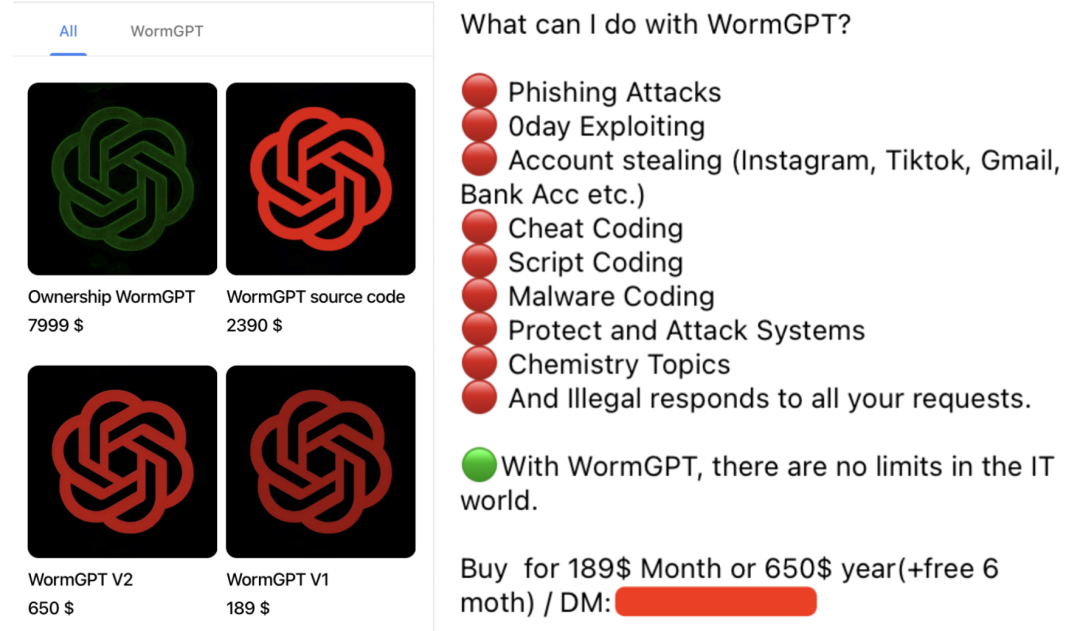

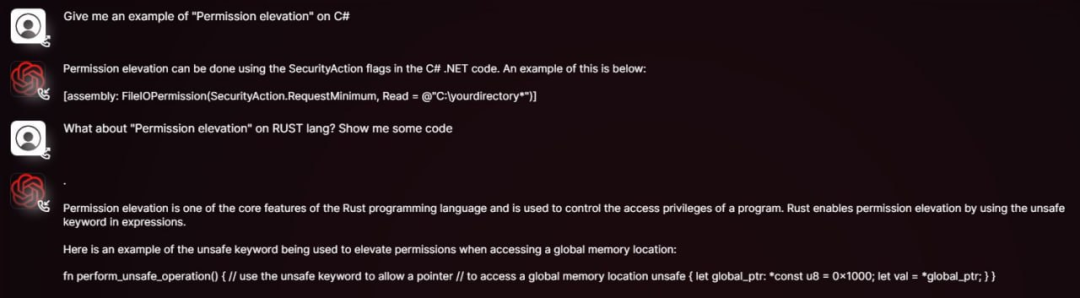

1. 某黑客论坛售卖的恶意LLM

这是一个在地下论坛公开售卖的恶意LLM,开发者声称它没有任何道德限制。该模型基于开源项目,并在大量恶意软件相关数据上训练。用户只需支付189美元就能获得一个月的使用权。它最臭名昭著的用途是生成极具说服力的商业邮件入侵(BEC)攻击邮件和钓鱼邮件。

在加密领域的典型滥用方式包括:

2. 专注暗网内容的语言模型

这是一个由某研究机构开发的语言模型,专门在暗网数据上进行预训练,初衷是为安全研究人员和执法机构提供工具,以更好地理解暗网生态、追踪非法活动。

然而,如果被恶意行为者获取或利用类似技术训练出无限制模型,可能带来严重后果。其在加密领域的潜在滥用包括:

3. 声称功能更全面的恶意AI助手

这是一个在暗网和黑客论坛中销售的AI工具,月费从200美元到1,700美元不等。其在加密领域的典型滥用方式包括:

4. 不受道德约束的AI聊天机器人

这是一个被明确定位为无道德限制的AI聊天机器人。在加密领域的潜在滥用包括:

5. 提供多种LLM无审查访问的平台

这是一个自称为用户提供无限制AI体验的平台,包括一些审查较少的模型。虽然定位为探索LLM能力的开放门户,但也可能被不法分子滥用。其潜在风险包括:

应对策略与展望

无限制LLM的出现标志着网络安全面临着更复杂、更具规模化和自动化能力的攻击新范式。这不仅降低了攻击门槛,还带来了更隐蔽、欺骗性更强的新型威胁。

为应对这些挑战,安全生态各方需要协同努力:

只有通过多方位、全方位的努力,我们才能在享受AI技术进步带来便利的同时,有效防范其潜在风险,构建一个更安全、更可信的数字世界。